Wenn es um den Einsatz neuer Technologien geht, sind die US-Amerikaner deutlich experimentierfreudiger als wir Bedenkenträger in der Alten Welt. Und während wir hier noch sehr zaghaft “Crime prediction”-Programme zur eventuellen Verhinderung von Wohnungseinbrüchen testen, ist “Künstliche Intelligenz” in den USA schon im vollen Praxis-Einsatz. Und liefert Richtern Einschätzungen darüber, wie hoch denn etwa die Rückfallwahrscheinlichkeit eines Angeklagten ist.

Das hat dann natürlich u.U. massive Auswirkungen auf das Urteil und das Strafmaß – kurz und knapp gesagt: Ein Algorithmus entscheidet (mit…) drüber, ob jemand in den Knast wandert und für wie lange. Ein Algorithmus einer privaten Firma, dessen interne Entscheidungskriterien aber völlig intransparent sind – für Richter, Delinquenten und Strafverteidiger. Spätestens seit dem Artikel bei Propublica im letzten Jahr ist klar – die KI ist alles andere als objektiv. Sie liefert für Schwarze einen signifikant höheren Rückfall-Risikoscore als für Weiße. Suresh Venkatasubramanian, Professor an der University of Utah, macht schon seit langem auf den Skandal aufmerksam – und auf die Ursachen.

Die KI lernt nämlich ihre vermeintlich “intelligenten” Weisheiten schlicht aufgrund der Trainingsdaten, mit der sie gefüttert wird. Und die Vorurteile, vor allem eben auch die unbewussten, die – um beim konkreten Beispiel zu bleiben – in menschlichen Urteilen, Gutachten und Prognosen stecken, kehren anschließend im trainierten Algorithmus wieder. Das reicht sogar bis in den Bereich der Semantik; bis zu den subtilen Nuancen, welche Begriffe positiv oder negativ besetzt sind, das hat vor kurzem ein Artikel im Fachblatt “Science” gezeigt: Noch nicht einmal unsere Sprache selbst ist objektiv.

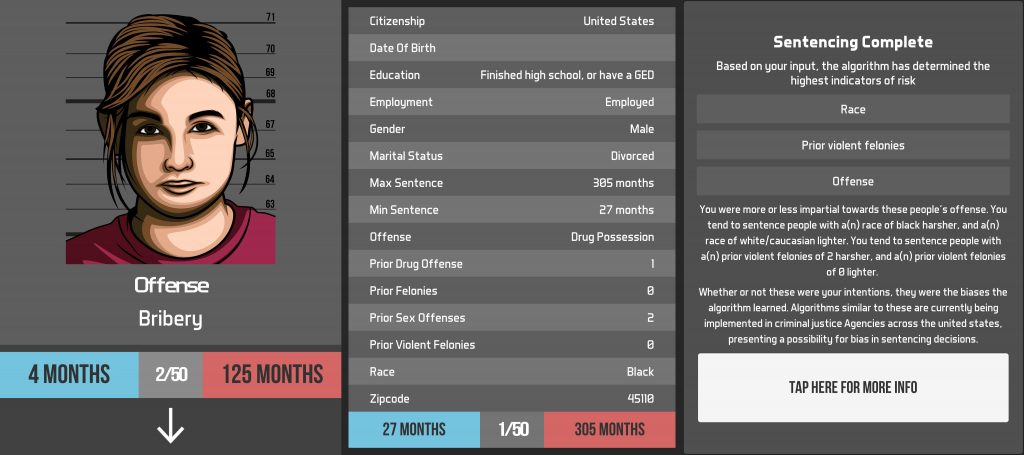

Wer einmal Richter spielen möchte und nachprüfen will, nach welchen Kriterien man selbst urteilen und Strafen verhängen würde, kann das mit der App “Justice” ausprobieren – die man dabei auch gleichzeitig trainiert, diese Kriterien ebenfalls zu übernehmen. Ob 50 (bzw. 45, anschließend “verurteilt” Justice selbst…) Versuche tatsächlich ausreichen, um alle möglichen Parameter für ein “unconscious bias” zuverlässig zu identifizieren, das bezweifle ich allerdings einmal. Auch die recht happigen (Minimal-) Strafmaße bei vielen Delikten machen die App für europäische Anwender vielleicht etwas unrealistisch bzw. dürften die Ergebnisse verzerren.

Für einen kurzen Test und eine kurze Erkenntnis reicht das Programm aber allemal: Die KI ist so subjektiv wie wir selbst.

Deutschlandfunk Nova · Justice-App: Selbst-Check von unbewussten Vorurteilen

Deutschlandfunk Nova – Hielscher oder Haase vom 02.05.2017 (Moderation: Diane Hielscher)