Das Wort „Captcha“ ist ein Akronym – ins Deutsche übersetzt steht es für „vollautomatischer öffentlicher Turing-Test zur Unterscheidung von Computern und Menschen“. Die Idee, so einen Mensch-Maschine-Test als Zugangskontrolle für Webseiten zu verwenden, stammt aus dem Jahr 2000; der Informatik-Professor Luis von Ahn gilt als der Erfinder. Und seit dem Jahr 2000 läuft ein sehr interessantes Wettrennen: Auf der einen Seite gibt es immer wieder neue Ansätze, Captchas automatisch zu knacken – und ebenso findige Experten sorgen anschließend im Gegenzug dafür, die gefundenen Schwachstellen auszubügeln.

Textbasierte Captchas, also die mit krakeliger, verzerrter Schrift sind nach wie vor die häufigsten – und bei einem Teil von ihnen erfüllt man als menschlicher Entzifferer ja sogar eine sinnvolle Aufgabe und hilft OCR-Algorithmen bei der Digitalisierung von Büchern oder der Erschließung von StreetMap-Bildern auf die Sprünge. Als besonders verlässlicher Mensch-Maschine-Test gelten die Text-Captchas aber schon seit Jahren nicht mehr – da automatische Bot-Scripte die Zugangshürden von Webseiten ja in einem massiven Dauerfeuer attackieren, reicht den Algorithmen schon eine niedrige Erkennungsrate aus, um genügend oft “durchzukommen”.

Die KI-Experten beim Venturekapital-Unternehmen “Vicarious” hatten übrigens selbst schon 2013 den Erfolg ihres “Recursive Cortical Networks” (RCN) beim Knacken von textbasierten Captchas vermeldet – damals aber noch ohne nähere Details zu nennen, wie das Ganze im Detail funktioniert. Das hatte verschiedene Motive, wie der Gründer von Vicarious, Dileep George, auf Anfrage erläutert: Zum einen habe man damals die Einzelheiten in Hinsicht auf die Sicherheitsauswirkungen im Netz zurückgehalten, zum anderen sei man seinerzeit noch ein sehr kleines Team gewesen und habe sich mehr Zeit bei der Entwicklung des Algorithmus und der Firma nehmen wollen.

Nicht ganz unwichtig dürfte dabei auch gewesen sein, dass das “Recursive Cortical Network”-Konzept praktisch das algorithmische “Kronjuwel” von Vicarious ist, das die Firma in den kommenden Jahren in einer Vielzahl von Bereichen, vor allem auf dem Feld der “Robotics” einsetzen und vermarkten will. Das wissenschaftliche Paper in “Science” mit den technischen Details reichte das Team also aus nachvollziehbaren Gründen erst ein, nachdem eine Reihe von Patenten auf RCN erteilt und veröffentlicht worden waren.Wie gravierend die direkten Auswirkungen auf die noch vorhandene oder ohnehin schon nicht mehr vorhandene Sicherheit von Text-Captchas in der Praxis sind, darüber kann man streiten. Das Vicarious-Team betont die wesentlich höhere Effizienz seines RCN-Ansatzes im Vergleich zu herkömmlichen “Brute-Force-Deep-Learning”-Angriffen. Ein Gegenargument lautet: Die wesentlich höheren Ressourcen-Anforderungen beim “Deep Learning” sind kein großes Problem, sie stehen allseits zur Verfügung – und wenn nötig, lässt sich menschliche Hilfe beim Annotieren von Trainingsmaterial sehr billig einkaufen; bei Crowdworking-Diensten wie “Amazon Mechanical Turk”. (Dass sich Menschen ja ohnehin im Zweifelsfall auch gratis für das Lösen der Zugangs-Rätsel einspannen lassen, das haben wir schon einmal vor sehr langer Zeit beleuchtet 🙂 )

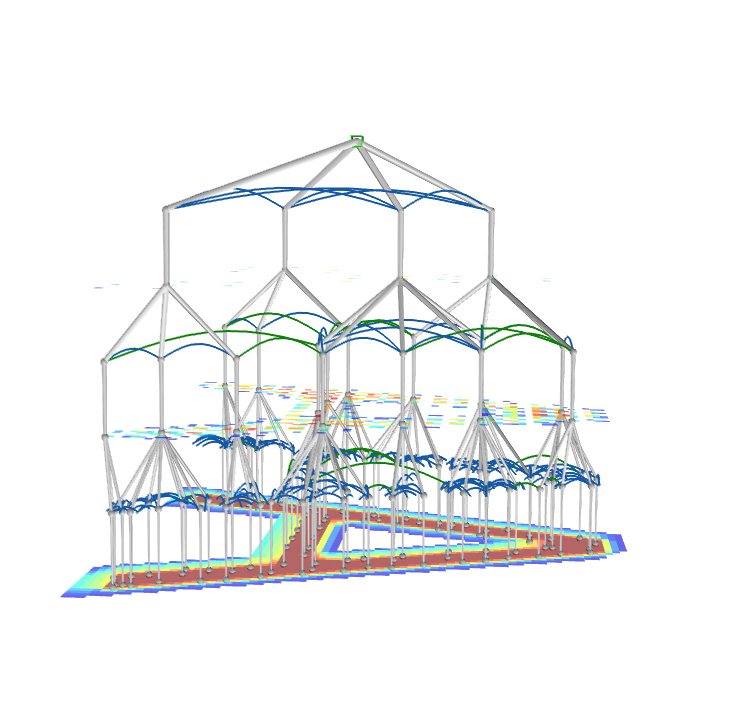

In comparison to RCNs, a deep neural network required a 50,000-fold larger training set to recognize a style of CAPTCHAs, and its accuracy deteriorated rapidly with even minor perturbations to the spacing of characters. [Credit: Vicarious AI]

Aber letztlich geht es natürlich bei RCN überhaupt nicht konkret um das Knacken von Captchas. Der Algorithmus setzt ähnlich wie die Handschrift-Erkennung aus einem früheren Science-Paper auf Generalisierung, auf ein Konzept, das sich in Jahrmillionen bei der Evolution biologischer neuronaler Strukturen bis hin zum menschlichen Gehirn herausgebildet und bewährt hat. Und insofern ist es ja schon eine philosophische Frage von allerhöchstem Interesse, welche Methode sich in künftigen KI- und Roboter-Entwicklungen durchsetzen wird. Wahrscheinlich wird die Antwort aber ganz pragmatisch sein: Wie die “Intelligenz” zustande kommt, ist sekundär. Haupsache, sie funktioniert in der konkreten Aufgabensituation.

Deutschlandfunk – Computer und Kommunikation vom 28.10.2017 (Moderation: Manfred Kloiber)

Bayerischer Rundfunk – BR5 Computermagazin vom 5.11.2017 (Moderation: Christian Sachsinger)